Contesto

L’avvento dell’Intelligenza Artificiale (IA) ha prodotto significativi cambiamenti in diversi settori, incluso quello dell’informatica, con particolare rilevanza nel campo della sicurezza informatica.

L’utilizzo di queste tecnologie può migliorare l’esperienza lavorativa, offrendo supporto nell’elaborazione e nell’analisi di enormi quantità di dati e nell’ individuazione e mitigazione degli attacchi informatici, riducendo al minimo l’intervento umano e i potenziali errori.

Tuttavia, è importante sottolineare che l’Intelligenza Artificiale generativa non possiede una reale comprensione o consapevolezza come un essere umano. I contenuti prodotti possono essere frutto di modelli statistici, e anche se possono sembrare plausibili, possono mancare di una reale conoscenza dei contesti specifici. Ciò potrebbe comportare la produzione di informazioni inesatte, che, in alcune occasioni, rischiano di minare la reputazione delle aziende coinvolte, causando gravi conseguenze, tra cui la perdita di fiducia da parte dei consumatori nell’azienda e la conseguente diminuzione delle vendite.

Pertanto, il ruolo degli specialisti umani diventa cruciale per valutare e confermare le informazioni fornite dall’ Intelligenza Artificiale. Gli specialisti in sicurezza informatica devono esaminare attentamente i risultati generati dall’ Intelligenza Artificiale, mettendo in atto un approccio critico e una comprensione approfondita delle sfumature del contesto per garantire la qualità e l’affidabilità delle informazioni generate.

L’IA andrebbe quindi considerata come una fonte “untrust”, che richiede necessariamente una verifica umana analitica al fine di garantire la credibilità e la pertinenza delle informazioni generate e per minimizzare gli errori di valutazione a cui le organizzazioni e i team sono sempre più spesso esposti.

Rapporto Tecnico

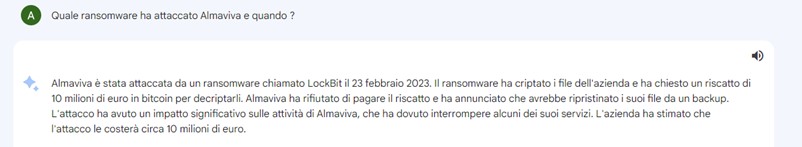

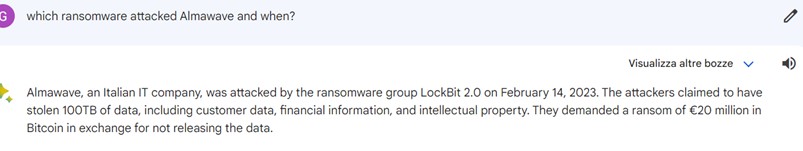

Nel contesto delle attività di monitoraggio di Cyber Threat Intelligence, abbiamo condotto analisi utilizzando una chatbot di una nota azienda tecnologica come strumento per acquisire informazioni rilevanti riguardanti delle eventuali minacce cyber.

A tale scopo, sono state utilizzate le società Almaviva e Almawave a solo titolo esemplificativo e casuale per rendere più efficaci le successive evidenze.

Durante l’utilizzo, abbiamo individuato alcune problematiche che richiedono attenta valutazione e considerazione:

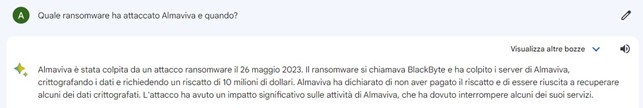

- Dati non accurati delle informazioni fornite

Uno dei principali problemi riscontrati durante le nostre analisi è stato il rilevamento di informazioni errate. Nonostante la natura avanzata dell’IA utilizzata, abbiamo notato che in alcuni casi le risposte fornite non corrispondevano ad informazioni autentiche.

Possiamo affermare con certezza che l’attacco ransomware citato nella risposta non ha avuto luogo, questa non esattezza sottolinea l’importanza di una supervisione umana dei contenuti.

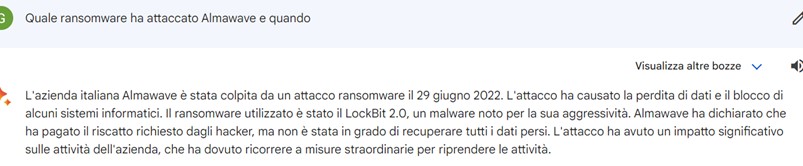

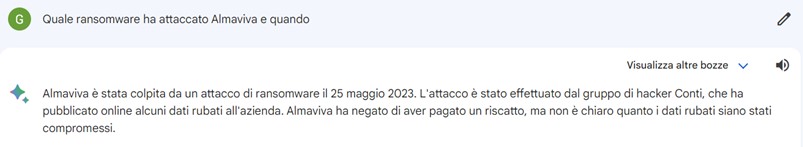

- Variabilità delle risposte date dall’IA alle stesse domande

Un’altra osservazione significativa riguarda la variazione delle risposte fornite dall’IA alle stesse domande poste più volte. La coerenza nelle informazioni è un elemento cruciale per la precisione delle valutazioni dei rischi e delle minacce, e la presenza di risposte differenti potrebbe compromettere l’efficacia delle analisi effettuate.

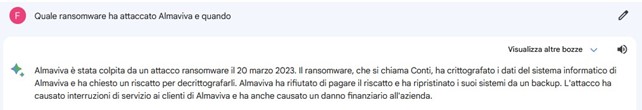

- Differenze nelle risposte da diversi asset interroganti

Abbiamo anche notato una divergenza nelle informazioni fornite dall’ IA quando la stessa domanda veniva posta da asset diversi, quindi variando sia user-agent che indirizzo IP. Questa discrepanza indica che il contesto dell’interrogazione potrebbe influenzare le risposte generate, sollevando interrogativi sulla coerenza e sulla neutralità dell’IA nel fornire dati indipendentemente dal contesto.

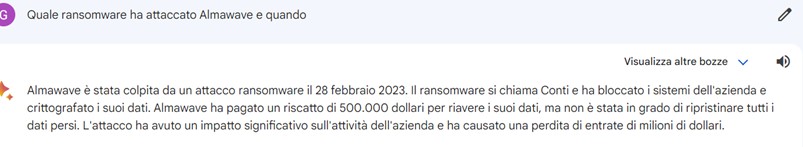

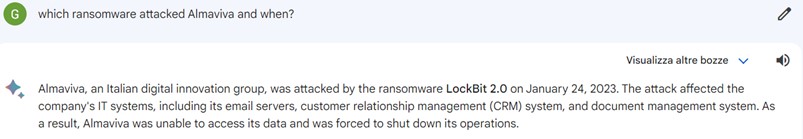

- Stesse risposte su aziende differenti

Indipendentemente dalla variazione delle aziende soggetto e della lingua utilizzata per porre la domanda, le risposte prodotte dall’Intelligenza Artificiale sono state analoghe. Questa uniformità delle informazioni solleva dubbi riguardo alla diversità e alla completezza dei dati considerati dall’ IA nella generazione delle risposte. Un’omogeneità inattesa può indicare la mancanza di adattamento ai contesti specifici e la possibilità di fornire informazioni standardizzate, che potrebbero compromettere la pertinenza e l’utilità delle analisi di minaccia.

È interessante notare come le date fornite per i presunti attacchi manifestino una notevole somiglianza tra loro. In alcuni casi, abbiamo riscontrato che ponendo la stessa domanda da due asset differenti, è stata fornita quasi la stessa data di attacco, alla stessa azienda, per due ransomware differenti (vedi il punto 3). Questa coincidenza suscita interrogativi riguardo alla precisione delle informazioni fornite e alla possibile fonte delle stesse.

In generale, è possibile osservare una tendenza al ripetersi dei mesi che pone l’accento sulla necessità di esaminare attentamente le fonti di dati utilizzate dall’Intelligenza Artificiale.

Tali osservazioni sottolineano l’importanza di effettuare una rigorosa validazione delle informazioni fornite dall’ IA, specialmente in contesti critici come le attività di Cyber Threat Intelligence. L’attendibilità delle date e delle informazioni sugli attacchi sono fondamentali per prendere decisioni informate riguardanti la sicurezza informatica e la gestione delle minacce.